In der Welt der Cyber Security und bei aktuellen Audits ist es nicht ungewöhnlich, dass Unternehmen bei Fragen zu Backup-Strategien schnell mit einem „Ja, wir haben ein Backup“ antworten. Aber ist das wirklich genug?

☝ Es ist wichtig, tiefer zu graben und kritische Fragen zu stellen:

➡ Wie steht es um den Recovery Point Objective (RPO)? – Dies misst, wie viel Datenverlust im Katastrophenfall tolerierbar ist.

➡ Was ist mit dem Recovery Time Objective (RTO)? – Die Zeit, die benötigt wird, um nach einem Vorfall wieder voll funktionsfähig zu sein.

➡ Und der Recovery Time Actual (RTA)? – Die tatsächliche Zeit, die für die Wiederherstellung benötigt wird.

➡ Gibt es offline und unveränderbare (immutable) Backups? – Diese sind entscheidend, um gegen Ransomware-Angriffe widerstandsfähiger zu sein.

➡ Existiert neben Datenbackups auch ein Konfigurationsbackup? – Es ist wichtig, nicht nur Daten, sondern auch Systemkonfigurationen zu sichern.

➡ Wurde für jedes Backup der erforderliche Schutzbedarf ermittelt? – Dazu gehört eine Business Impact Analysis (BIA) und ein Business Continuity Management (BCM).

🌐 BIA (Business Impact Analysis): Diese Analyse hilft dabei, die potenziellen Folgen eines Unterbrechungsereignisses zu verstehen. Sie identifiziert kritische Geschäftsprozesse und die Auswirkungen, die deren Ausfall oder Störung auf das Unternehmen haben könnte. Dies ist entscheidend für die Entwicklung einer effektiven Strategie zur Risikominderung und Priorisierung der Wiederherstellungsmaßnahmen.

🌐 BCM (Business Continuity Management): BCM ist der umfassende Ansatz, um sicherzustellen, dass die essenziellen Funktionen eines Unternehmens während und nach einer Krise weiterlaufen können. Es umfasst nicht nur die Wiederherstellung von Daten und IT-Infrastruktur, sondern auch die Aufrechterhaltung aller Aspekte der Geschäftstätigkeit unter außergewöhnlichen Bedingungen.

Ein umfassender Ansatz zur Datensicherung ist unerlässlich, um die Resilienz gegen Cyber-Bedrohungen zu stärken. Es geht nicht nur darum, ein Backup zu haben, sondern um das Verständnis und die Implementierung einer Strategie, die allen Aspekten der Datenwiederherstellung gerecht wird.

Autor: florianlaumer

„Natürlich haben wir eine Firewall!“

🔐 „Natürlich haben wir eine Firewall!“ – Auch diese Aussage ist in Unternehmensaudits oft schnell abgehakt oder auch bei einigen „kostenlosen“ Cyber Security Checks.

Aber warten Sie mal… Firewall ist nicht gleich Firewall! 😎

🤔 Sollte ein Saugroboter zusammen mit der SIRI oder ALEXA, Gästen, Überwachungskameras oder dem Thermomix im selben Netzwerk wie kritische Betriebsanlagen Daten empfangen?

Bei der Einrichtung von Unternehmensnetzwerken spielt somit die Netzwerksegmentierung eine entscheidende Rolle. Hierbei geht es darum, verschiedene Netzwerkbereiche voneinander zu trennen – wie IT (Informationstechnik), OT (Operational Technology – also technologische Systeme, die physische Prozesse steuern in der Produktion) und den Gästebereich.

🛡️ Die Effizienz einer Firewall hängt ebenfalls von den definierten Regeln ab. Hier sind einige wesentliche Regeltypen und ihre Bedeutung – einfach erklärt:

🔐 Port-Based Rules: Bestimmte „Türen“ (Ports) in Ihrem Netzwerk werden geöffnet oder geschlossen, um den Verkehr zu kontrollieren.

🔐 IP Address Filtering: Nur bestimmte Adressen (IPs) dürfen auf Ihr Netzwerk zugreifen oder werden blockiert.

🔐 Protocol-Based Filtering: Dies regelt, welche Arten von Datenpaketen (basierend auf ihrem Protokoll, wie HTTP oder FTP) durchgelassen werden.

🔐 Time-Based Filtering: Zugang wird nur zu bestimmten Zeiten erlaubt. Praktisch für Zugriffsbeschränkungen außerhalb der Arbeitszeiten.

🔐 Stateful Inspection: Überwacht aktive Verbindungen, um sicherzustellen, dass eingehende Datenpakete Teil einer legitimen Verbindung sind.

🔐 Application-Based Rules: Steuert den Zugriff basierend auf der Anwendung, die die Daten sendet oder empfängt.

💡 Wichtig ist, diese Regeln regelmäßig zu überprüfen und anzupassen. Cybersecurity ist kein „Set-and-Forget“ – es erfordert ständige Aufmerksamkeit und Anpassung.

Warum Ihre IT-Abteilung nicht immer der beste Hüter Ihrer Informationssicherheit ist

Stellen Sie sich vor, Sie haben einen Automechaniker des Vertrauens, der wortgewandt und kompetent wirkt. Würden Sie sich allein auf sein Wort verlassen, oder würden Sie Ihr Auto für eine unabhängige Inspektion zum TÜV bringen, um sich messbar abzusichern? Oder ein anderes Beispiel: Sie fühlen sich gesund und haben einen Hausarzt, dem Sie vertrauen. Er ist erfahren und gibt Ihnen zumindest das Gefühl, in guten Händen zu sein. Würden Sie sich ausschließlich auf sein Urteil verlassen? Oder würden Sie für spezifische Gesundheitsfragen auch Fachärzte aufsuchen oder regelmäßige Vorsorgeuntersuchungen durchführen lassen, um eine umfassende Einschätzung Ihres Gesundheitszustandes zu bekommen?

Genauso verhält es sich mit der Informationssicherheit in Unternehmen. In einer Zeit, in der digitale Bedrohungen (BSI) stetig zunehmen, ist der Schutz sensibler Daten und Systeme entscheidend.

Viele Unternehmen verlassen sich auf ihre IT-Abteilungen, doch sind diese wirklich immer die besten Ansprechpartner für Informationssicherheit? In diesem Blogbeitrag werfe ich einen Blick auf die Herausforderungen, denen sich IT-Abteilungen stellen müssen, und erörtere, warum eine regelmäßige externe Überprüfung des Status quo der Informationssicherheit unerlässlich ist – um aus der vermeintlich „gefühlten“ Sicherheit eine messbare zu machen.

Die Grenzen der IT-Abteilungen

Interne und externe IT-Abteilungen spielen eine entscheidende Rolle im täglichen Betrieb eines Unternehmens. Sie sorgen für den reibungslosen Betrieb der technischen Infrastruktur, beheben Störungen und sind oft die ersten Ansprechpartner bei IT-bezogenen Fragen. Doch wenn es um die Informationssicherheit geht, stoßen selbst die kompetentesten Teams an ihre Grenzen.

Hier ist es wichtig zu verstehen, dass IT-Sicherheit und Datenschutz zwar eng miteinander verbunden sind, aber nicht identisch. Während der Datenschutz (z.B. durch die DSGVO) darauf abzielt, personenbezogene Daten zu schützen, konzentriert sich die IT-Sicherheit auf den Schutz aller Informationen des Unternehmens, die einen entsprechenden Schutzbedarf aufweisen.

In Diskussionen über die IT-Sicherheit höre ich häufig zuversichtliche Aussagen wie „Ich glaube, wir sind ganz gut aufgestellt“ oder „Ich habe da ein sehr gutes Gefühl bei unserer Sicherheitslage.“ Viele berufen sich dabei auf gängige Schutzmaßnahmen: „Wir haben eine Firewall, weisen auf Phishing hin und nutzen Antivirus-Programme. Außerdem haben wir ein Backup.“ Oft wird dabei die Unvollkommenheit der Sicherheit akzeptiert: „100%ige Sicherheit gibt es sowieso nicht.“ Nicht selten hört man auch die Einschätzung von externen Dienstleistern: „Der externe Administrator meint, das passt alles und ist alles ganz easy.“ Einige neigen sogar zur Unterschätzung des Risikos: „Es wird schon nichts passieren, solche Angriffe treffen doch nur die großen Unternehmen.“

Doch diese Annahmen werden durch die Realität oft widerlegt. Studien, wie jene von TÜV-Verband, zeigen, dass es eine hohe Dunkelziffer ungemeldeter Sicherheitsvorfälle gibt – schätzungsweise 82% der Fälle werden nicht berichtet. Dies deutet darauf hin, dass selbst Basismaßnahmen wie Firewalls, Antivirus-Programme und Backups, besonders wenn diese nie getestet wurden ;), nicht ausreichen. Häufig fehlen erprobte Notfallpläne, MFA-Sicherung für Admin-Passwörter und eine adäquate Segmentierung veralteter Systeme vom Netzwerk.

Betriebsblindheit und fehlende Qualifikationen

Ein wesentliches Problem ist die Betriebsblindheit: Wer tagtäglich mit den gleichen Systemen arbeitet, dem fällt es schwer, Schwachstellen zu erkennen. Hinzu kommt, dass IT-Abteilungen oft nicht die notwendige Ausbildung und Zertifizierung, wie beispielsweise die eines ICO Security Officer nach ISO-27001 oder Certified Information Security Manager (CISM), vorweisen können. Während sie technologisch bezüglich Firewalls, Windows etc. zertifiziert sein mögen, bleibt oft keine Zeit für weiterführende Qualifikationen im Bereich Informationssicherheit und Cyber Security.

Die Rolle der Geschäftsführung

Es ist entscheidend zu verstehen, dass die ultimative Verantwortung für die Informationssicherheit bei der Geschäftsführung liegt und nicht allein bei der IT-Abteilung.

Eine umfassende Sicherheitsstrategie erfordert das Engagement und die Unterstützung der obersten Führungsebene.

Darüber hinaus kann die Verantwortung für die IT-Sicherheit nur dann vollständig erfüllt werden, wenn nachweisbar ist, dass die Geschäftsführung ihrer Sorgfaltspflicht nachgekommen ist.

Dies lässt sich beispielsweise durch einen externen Audit, wie einem Cyber Security Check, dokumentieren. Ein solcher Nachweis ist essenziell, um zu bestätigen, dass die erforderlichen Maßnahmen der Geschäftsführung zur Gewährleistung der Informationssicherheit tatsächlich implementiert und wirksam sind.

Die Notwendigkeit einer unabhängigen Überprüfung

Um ein hohes Maß an Informationssicherheit zu gewährleisten, halte ich es für entscheidend, regelmäßig eine externe Überprüfung des Status quo durchzuführen. Solche Überprüfungen sollten idealerweise von qualifizierten Auditoren des ITQ-Instituts oder ähnlichen Institutionen, basierend auf dem BSI IT-Grundschutz und ISO 27001, durchgeführt werden. Es ist wichtig, dass diese Cyber Security Checks nicht nur eine nachweisbare Anzahl von durchgeführten Prüfungen aufweisen, sondern auch hohen Qualitätsanforderungen entsprechen und auf umfangreichen Erfahrungswerten basieren.

Neben der Identifizierung von Schwachstellen sollten solche Checks auch praxisorientierte Gegenmaßnahmen empfehlen und eine fundierte Kalkulationsgrundlage für deren Umsetzung bieten. Statt sich auf einfache Werkzeuge wie Excel-Listen oder sogenannte „QuickChecks per Quiz“ zu verlassen, sollten fortschrittliche Portale verwendet werden, die eine detaillierte Analyse und Nachverfolgung ermöglichen.

Zudem ist es essenziell, dass diese Sicherheitschecks fortlaufend an die aktuelle Bedrohungslage angepasst werden, wie sie vom Bundesamt für Sicherheit in der Informationstechnik (BSI) definiert wird. Dies stellt sicher, dass Unternehmen nicht nur auf aktuelle Risiken reagieren, sondern auch proaktiv Maßnahmen ergreifen können, um sich gegen zukünftige Bedrohungen zu wappnen. Eine unabhängige Perspektive ist dabei unerlässlich, um blinde Flecken zu erkennen und Schwachstellen aufzudecken, die den internen Teams bisher verborgen geblieben sind.

Zukünftige Anforderungen und kontinuierliche Verbesserung

Mit Blick auf zukünftige Regelungen wie die NIS-2-Richtlinie, die die Cybersicherheitsanforderungen erweitert und die Sanktionen verstärkt, um das Sicherheitsniveau in den EU Mitgliedstaaten zu harmonisieren und zu verbessern, wird es für Unternehmen sogar verpflichtend, das Thema Cyber Security und Risikomanagement auf die Agenda zu nehmen. Die NIS-2-Richtlinie enthält strengere Anforderungen für den Mittelstand (< 50 Mitarbeiter und < 10 Mio. Umsatz in bestimmten Sektoren).

Ein Whitepaper dazu habe ich hier bereitgestellt: NIS-2 Whitepaper PASSION4IT

Fazit

Während interne und externe IT-Abteilungen eine zentrale Rolle im täglichen IT-Betrieb spielen, sind sie nicht immer die besten Hüter der Informationssicherheit. Betriebsblindheit, Ressourcenmangel und die Komplexität des Themas machen eine externe Überprüfung unerlässlich. Cybersecurity ist ein laufender Prozess, der kontinuierliche Aufmerksamkeit und Anpassung erfordert. Daher gehört dieses Thema fest auf die tägliche Agenda der Unternehmensführung. Durch die Kombination interner und externer Ressourcen kann ein umfassender Schutz sensibler Daten und Systeme sichergestellt und kontinuierlich verbessert werden. So wird aus der vermeintlich „gefühlten“ Sicherheit eine messbare, und Ihr Unternehmen bleibt auch in der sich schnell verändernden digitalen Welt sicher und geschützt.

Nach DSGVO kommt nun NIS-2 auf die Unternehmen zu.

Wir alle erinnern uns noch gut daran, wie die Einführung der DSGVO (Datenschutz-Grundverordnung) vor ein paar Jahren für Aufregung und Unruhe in der Geschäftswelt sorgte. Datenschutz wurde zur Chefsache, Compliance-Teams wurden gestärkt, und Unternehmen mussten sich anpassen.

Jetzt steht schon das nächste Kapitel in Sachen Cybersecurity und Informationsschutz vor der Tür: NIS-2 (Network and Information Systems Directive 2). Aber bevor wir in Panik ausbrechen, lassen Sie uns einen klaren Kopf bewahren. Noch ist etwas Zeit, sich vorzubereiten.

In meinem aktuellen Whitepaper habe ich alle wichtigen Fakten, Informationen und Ressourcen für den Mittelstand zusammengefasst. Dieses Dokument ist eine Pflichtlektüre, denn die Umsetzung von NIS-2 wird genauso wie die DSGVO Chefsache sein.

📚 Hier finden Sie das Whitepaper zum Download bei PASSION4IT.

NIS-2 bringt einige Herausforderungen mit sich, insbesondere für Unternehmen, die dann (ab Oktober 2024) als „kritische Infrastrukturen“ eingestuft werden. Doch genau wie bei der DSGVO geht es auch hier darum, die Sicherheit unserer digitalen Welten zu erhöhen und den Schutz unserer Informationen zu gewährleisten.

Ich empfehle dringend, sich bereits jetzt mit den Anforderungen von NIS-2 vertraut zu machen und Ihre Vorbereitungen zu beginnen. Die Zeit läuft, und eine frühzeitige Umsetzung wird dazu beitragen, mögliche Stolpersteine zu vermeiden.

Lassen Sie uns gemeinsam diese neue Herausforderung annehmen und unsere Unternehmen für die Zukunft stärken. Ich und PASSION4IT GmbH sind hier, um Sie auf diesem Weg zu unterstützen.

#NIS2#Datenschutz#Cybersecurity#Compliance#Mittelstand#Unternehmenssicherheit#PASSION4IT

Certified SAFe® 6 Agilist

A Certified SAFe® 6 Agilist (SA) is a SAFe Enterprise leadership professional who leads and sustains the Lean-Agile transformation. Key areas of competency include the application of Lean-Agile mindset and principles, the release of value through Agile Release Trains (ARTs), and building an Agile portfolio to align strategy and execution.

LEAD Digital Transformation Analyst

I am very proud that I received my LEADing Practice Digital Transformation Analyst Certification. Now I can call myself LEADing Practice #DigitalTransformationAnalyst. Special thanks to Jamie Caine FHEA, Georg Etzel and Mark von Rosing for their support. #digitaltransformation #innovation

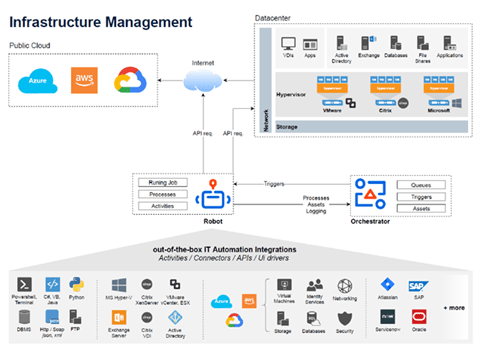

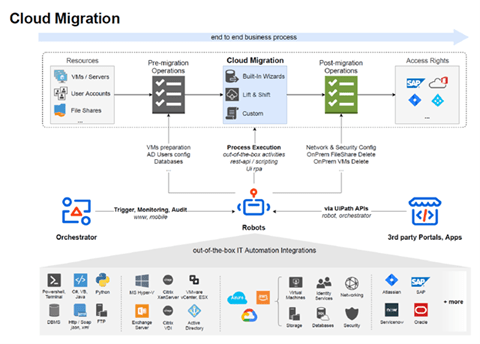

ACHT CHANCEN DURCH ROBOTIC PROCESS AUTOMATION

Bei der IT-Automatisierung geht es darum, mithilfe von Softwaretools wiederkehrende IT-Aufgaben zu verwalten – mit nur minimalem Eingriff seitens der IT-Administratoren. Diese können sich somit anderen Aufgaben widmen, statt Routinejobs zu erledigen. Mit der Robotic Process Automation lassen sich Arbeitsaufwand und Kosten nochmals deutlich senken sowie weitere Prozesse automatisieren, für die das früher undenkbar gewesen wäre.

Die Robotic Process Automation (RPA, zu Deutsch: robotergesteuerte Prozessautomatisierung) hilft dabei, die Wirtschaftlichkeit sämtlicher Prozesse und zugehöriger Tasks und somit letztlich auch des Unternehmens zu steigern. Das erreicht sie, indem sie die kostspieligsten Phasen der Bereitstellung, des Designs und der Entwicklung sowie der Wartung von IT-Prozessen vereinfacht. Zu diesem Zweck werden verschiedene Ansätze verfolgt, beispielsweise die Vereinfachung der RPA-Programmierung (gemäß der RPA-Tendenz Low Code) oder die Entwicklung des Selbstlernens und der kognitiven Automatisierung.

Durch die Nutzung von Process Mining, Task Mining, der Verarbeitung natürlicher Sprache (NLP), der optischen Zeichenerkennung (OCR) und des maschinellen Lernens wird die Kategorie der automatisierbaren Prozesse und Tasks erweitert. Die RPA-Anwendungsbereiche werden über Supportfunktionen hinaus auf komplexere Vorgänge wie End-to-End-Kundendienst mit Chatbots, Durchführung von KYC-Überprüfungen (Know Your Customer) über handschriftliche Kundeneingaben oder gescannte Dokumente erweitert.

Da RPA immer intelligenter, ausgefeilter und breiter anwendbar wird, wird sie auch zur Verbesserung des Leistungsniveaus von IT-Abteilungen eingesetzt. Die robotergesteuerte Prozessautomatisierung wird somit den IT-Betrieb im Laufe der Zeit verändern.

Nach dieser allgemeinen Beschreibung möchten wir im Folgenden das Potenzial von RPA auf den Punkt bringen, indem wir acht konkrete RPA-Anwendungsfälle für die IT erläutern.

Reale Anwendungsfälle der IT-Automatisierung

Die Verwendung von RPA zur Änderung des IT-Betriebs führt zu einer Steigerung der Prozessqualität, einer Verkürzung der Servicebereitstellungszeit und Wiederherstellungszeit, zu einer Steigerung der Produktivität der IT-Ressourcen und infolge all dieser Maßnahmen zu einer allgemeinen Verbesserung der betrieblichen Effizienz. In der folgenden Liste finden Sie sowohl Back- als auch Front-End-Prozesse.

1. Backup- und Patch-Management

Dies sind routinemäßige, sich wiederholende Aufgaben, die eine sorgfältige Behandlung erfordern, ohne dass sie Mitarbeitern, die sie manuell ausführen, ein Gefühl der Erfüllung oder Arbeitszufriedenheit verschaffen (häufig im Gegenteil!). Ihr Unternehmen kann jedoch nicht ohne sie auskommen. Dies ist also eine typische Art von Prozess, der von den Schultern der Mitarbeiter entfernt und der RPA-Technologie zugewiesen werden kann.

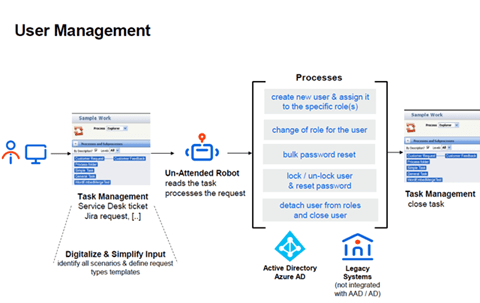

2. Passwort zurücksetzen

Anforderungen zum Zurücksetzen von Passwörtern sind wiederholbar, haben eine typische und konsistente Struktur und wenige Ausnahmen. Folglich ist der Prozess ein Hauptkandidat für die Automatisierung. Sie müssen lediglich Softwarerobotern bestimmte Vorlagen (Anforderung, Bestätigung und so weiter) sowie den Zugriff auf das ITSM-Tool (IT Service Management) für Active-Directory-Aktivitäten bereitstellen.

3. Benutzerverwaltung

Durch die Nutzung von Bots in der IT-Abteilung für Aktivitäten wie beispielsweise die Kontoerstellung oder die Erstellung von E-Mail-Adressen werden die Vorteile in die Personalabteilung übertragen. Besonders bei der Übernahme von Unternehmen oder der Neueinführung von Anwendungen und der zugehörigen Benutzerkonfiguration können diese Vorteile voll ausgespielt werden. Nach dem Sammeln von Benutzerprofilinformationen für die Kontoerstellung können Softwareroboter, die mit Zugriff auf das ITSM-Tool ausgestattet sind, diese gemäß den HR-Vorlagen strukturierten Informationen verwenden und eine Serviceanforderung zur Benutzeranlage generieren.

4. Senden von Benutzerbenachrichtigungen

Das tägliche manuelle Senden von Hunderten von E-Mail-Benachrichtigungen kann den Workflow ernsthaft stören. Das Gute an den Benutzerbenachrichtigungsprozessen ist, dass sie mithilfe vorgegebener Regeln ausgeführt werden, die auf strukturierte Informationen angewendet werden. Daher ist eine End-to-End-Automatisierung (über unbeaufsichtigte Roboter) eine praktikable Option.

Ein Taskplaner kann einen Bot dazu veranlassen, sich beim ITSM-Tool anzumelden, um die ausstehenden Fälle zu erfassen und die erforderlichen Berichte auszuführen (beispielsweise E-Mails senden, die auf Benutzereinstellungen zugeschnitten sind, Überwachungsberichte senden, Ticketstatus aktualisieren). Wie in den vorherigen Anwendungsfällen werden Ausnahmen, wenn sie auftreten, an Service-Desk-Mitarbeiter gesendet, oder sogar sofort gelöst. Die Automatisierung verkürzt die Verarbeitungszeiten, verbessert die Servicequalität und ermöglicht es den Mitarbeitern, sich auf höherwertige Aufgaben zu konzentrieren.

5. Incident Management

Nicht alle Incidents erfordern menschliches Eingreifen von Experten. Mit einem automatisierten Diagnosedienst können Softwareroboter die Probleme auswählen, die mithilfe einfacher, regelbasierter Algorithmen behoben werden können, und nur diejenigen an Fachexperten weiterleiten, die komplexere Entscheidungen erfordern. Angesichts der Verfügbarkeit virtueller IT-Mitarbeiter rund um die Uhr reduziert die Automatisierung die durchschnittliche Lösungszeit und die Reaktionszeiten erheblich und erhöht so die Kundenzufriedenheit.

6. Netzwerkunterstützung

Netzwerktechnologien wie Load Balancer oder Firewalls erfordern eine ständige Überwachung und Messung. Softwareroboter können die Netzwerkleistung verwalten und sofortige Updates und Optimierungen ausführen, wenn sich Verbesserungsmöglichkeiten ergeben. Ihre konsistenten, dauerhaften und fehlerfreien Betriebsmodi stellen sicher, dass in der IT-Automatisierung alle Vorteile der Netzwerkoptimierung genutzt werden.

7. Softwareinstallationen

RPA bietet die Möglichkeit, selbst komplexe Systeme mit miteinander verbundenen Bestandteilen durch die grundlegendsten Aktionen mit nur einem Klick zu installieren. Mit der IT-Automatisierung sind wir also buchstäblich nur einen Klick von der Softwareinstallation entfernt.

8. Überwachung der Benutzererfahrung

Die Automatisierung dieses Prozesses wird durch die Tatsache ermöglicht, dass RPA menschliches Verhalten nachahmt. Da Bots die Erfahrungen von Mitarbeitern und Kunden simulieren können, ermöglichen sie kontrollierte Tests von Softwareanwendungen. Die direkten Nutznießer sind die Kunden, deren Benutzererfahrung verbessert wird und die von der qualitätsgesicherten Bereitstellung neuer Softwareversionen profitieren. Dies wird sich zum Vorteil des Unternehmens auswirken, das langfristig Gewinne erzielen und seinen guten, personenzentrierten Ruf festigen wird.

RPA & KI: Ziemlich beste Freunde – DOK. Magazin 05 2019

#Intelligent-Process-Automation, #Machine-Learning-Technologien,

#Natural-Language-Processing, #OCR, #Centre of Excellence (CoE)

RPA und KI werden immer öfter im gleichen Kontext erwähnt:

Beide Technologien werden als Wunderwaffe angepriesen, um

Unternehmensprozesse bzw. einzelne Tasks zu optimieren. Bei

RPA geht es in erster Linie darum, Geschwindigkeit, Qualität und

Mitarbeiterzufriedenheit zu optimieren. Das Problem mit der KI

ist − kurz gesprochen −, dass sie kompliziert und schnelllebig

ist. In letzter Zeit wurden enorme Fortschritte bei der Verarbeitung

von Sprache, maschinellem Lernen oder Bilderkennung

gemacht.

Anschaulich wird der Zusammenhang zwischen RPA und KI

anhand der Darstellung von einigen konkreten Anwendungsfällen.

Um einen Aspekt gleich vorweg zu nehmen: RPA Prozesse

werden immer nur so intelligent sein, wie diese vom Menschen

„erschaffen“ werden. Grundlage sind der bestehende − und

meistens auch für RPA anzupassende − Prozess und das entsprechende

„Wissen“. Die Automatisierung einzelner Tasks ist die

erste RPA-Hürde und der Einsatz von KI kann dabei eine durchaus

stark unterstützende Technologie darstellen.

Wie sieht RPA konkret aus − und wozu wird KI

benötigt?

„Content Services“ – Sind diese nun die Chance für eine erfolgreiche digitale Transformation?

Erste Veröffentlichung in der Jubiläums-Newsletter-Ausgabe „25 Jahre PROJECT CONSULT“

Mittlerweile spricht jeder von der „digitalen Transformation“ oder von „Digitalisierung“. So mancher Marketingflyer wurde schnell mit dieser Begrifflichkeit aktualisiert, ohne sich groß Gedanken zu machen. Wenige sprechen von der „digitalen Transition“, also dem Wechsel der Zuständigkeit der neuen Verantwortlichkeiten, was dies technologisch und vor allem organisatorisch wirklich für Unternehmen bedeutet. Und nun soll auch noch ECM den „Content Services“ weichen.

Die digitale Transformation hat zwei Dimensionen: die Digitalisierung von Geschäftsmodellen und die Digitalisierung von Geschäftsprozessen.

Bei der Digitalisierung von Geschäftsmodellen geht es um die Anpassung bestehender und um die Entwicklung ganz neuer Produkte und Dienste. Häufig führt dies zu disruptiven Innovationen.

Die Perspektive der Digitalisierung der Geschäftsprozesse ist vor allem auf höhere Effizienz, Margen und Produktivität, auf eine Senkung von Kosten und eine Verbesserung der Leistungsfähigkeit gerichtet.

Womöglich ist dadurch schon jeder etwas genervt von diesem Hype, der gerade durch die IT Welt getrieben wird. Ähnlich wie beim Thema „Cloud“ hat hier jeder seine eigene Sicht darauf – je nach Hintergrund, Reifegrad und Erfahrungen. Auch so manche Schatten IT Analyse ergibt überraschende Erkenntnisse, wie „digital“ so manches Unternehmen doch schon ist. Auch eine Darknet Analyse über das eigene Unternehmen kann überraschend sein.

Wenn heutzutage Prozesse digitalisiert oder vorhandene Applikationen modernisiert werden, dann spielt verstärkt auch das Thema „Cloud“ eine Rolle. Durch moderne Software-Architekturen wird sichergestellt, dass Applikationen Cloud-Ready oder gar Cloud-First entwickelt werden. Damit IT-Entwicklungsabteilungen und deren Dienstleister überhaupt in die Lage versetzt werden für eine Public-Cloud zu entwickeln, müssen klare Vorgaben gemacht werden. Microsoft Azure oder Amazon AWS bieten mittlerweile hunderte verschiedener Services, die von Entwicklern genutzt werden können. Genau hier liegt die Herausforderung: durch die zentrale IT muss sichergestellt werden, dass nur ein gewisses Subset von Services von Entwicklern genutzt werden darf. Die IT erarbeitet und empfiehlt dazu Referenzarchitekturen für bestimmte Anwendungsfälle (z.B. Web-Anwendung mit Datenbank, Backend für mobile App, Office365-App) und macht Vorgaben (z.B. bzgl. Monitoring, Logging, Deployment, Integration, Zugriffssicherheit oder Datensicherheit) um einen späteren Applikationsbetrieb gewährleisten zu können.

Und schon ist an den grundlegenden Themen zu arbeiten, um generell die gesamte IT in der organisatorischen und vor allem strategischen Ausrichtung neu aufzustellen (z.B. weg von der klassischen IT Betriebseinheit, hin zum modernen internen Service Provider). Die angedachte Transformation dauert dann doch noch etwas an, da die IT Abteilung z.B. erst „Cloud ready“ gemacht werden muss und ein Assessment dazu initiiert wird inkl. Reifegradermittlung.

Nur zu digitalisieren, des Digitalisierens wegen, macht keinen Sinn. Ebenfalls wichtig zu erkennen wäre, wie z.B. der Digitalisierungsgrad im Unternehmensportfolio aussieht, und was den Anwendern bereits an Services angeboten wird. Macht es wirklich Sinn, mit IoT, Mobile Apps oder anderen modernen Technologien nach außen top aufgestellt zu sein, jedoch seinen Mitarbeiten noch veraltete Arbeitsweisen anzubieten? Kann denn überhaupt eine „digitale Transformation“ ohne eine „Social Collaboration Strategie“ stattfinden? Gehört nicht beides konsequent zusammen? Meiner Meinung nach ein deutliches Ja.

Was hat das mit ECM und Digitalisierung zu tun?

ECM als Akronym wird schon lange emotional diskutiert. Meiner Meinung nach ist eine erfolgreich umgesetzte und gelebte ECM Strategie eine der grundlegenden Komponenten jeder digitalen Transformation und somit das Herzstück davon. Denn heute scheitert der Schritt in die Informationswelt oft schon daran, dass die benötigten Informationen erst gar nicht zur Verfügung stehen und sie dann in einem zweiten Schritt erst einmal klassifizieren werden müssen, um diese verwerten zu könnten.

Als zweite Komponente kommt die IT Readyness aus verschiedenen Perspektiven dazu, mit den neu zu implementierten Service-, Security-, Cloud- oder Datacenter Konzepten.

Mittlerweile wird in der Informationsmanagement Szene nun von „Content Services“ gesprochen. Genauer unter die Lupe genommen, könnten diese doch die neue strategische Chance sein, die erhoffte digitale Transformation endlich in den Griff zu bekommen? Eine solide Evolution, wenn davor die internen „ECM“ Hausaufgaben gemacht wurden und die Unternehmens IT „ready“ ist?

Was hat es nun mit den Content Services auf sich?

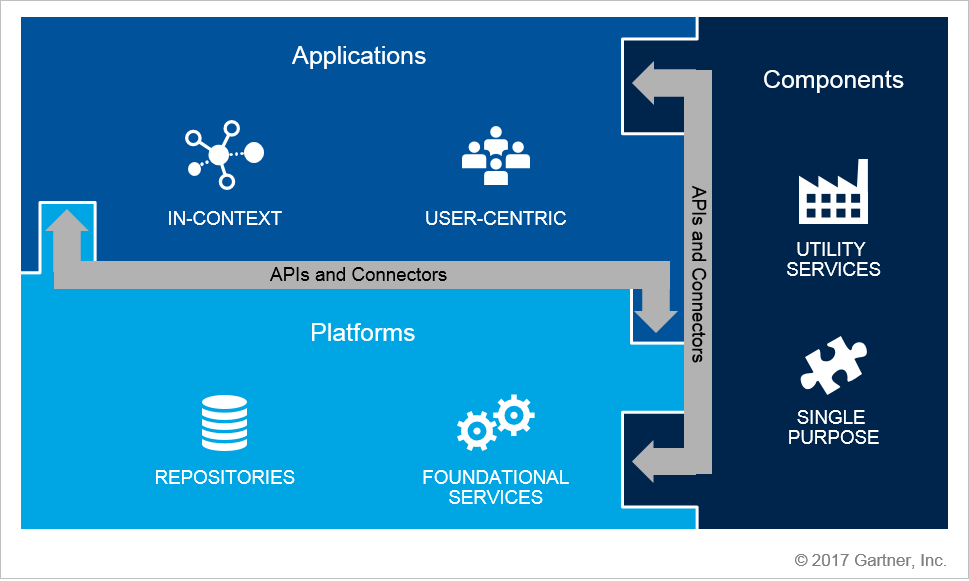

Gartner „CSP Framework“ Grafik aus dem Beitrag von Hanns Köhler-Krüner.

Infrastruktur

Die Infrastruktur Schicht bildet Server und Software Komponenten wie SQL-Server Database, Cache, Repository und IIS Web Service ab. Diese elementaren Komponenten sind Voraussetzung für den reibungslosen Betrieb einer Content Plattform.

Content Plattform

In der Content Plattform Schicht wird eine Vielzahl essentieller Kernfunktionen bereitgestellt, die wiederum in der Content Applikation Schicht konsumiert werden können. Die Kernfunktionen sind generisch aufgebaut und können in jedem Szenario wiederverwendet werden. Content Plattformen dienen generell als technologische Basis für eine Vielzahl von web-basierten Fachanwendungen. Diese spezifischen Fachanwendungen nenne ich einfach mal Szenarien.

Content Plattformen dienen also als Basistechnologie. Vorgefertigte Module erlauben die schnelle Abbildung kundenspezifischer Prozesse bis hin zu komplexen Geschäftsmodellen.

Content Applikation

Ein wesentliches Merkmal sind anschließend die Content Applikationen, die sogenannten Szenarien. Diese Szenarien (Apps, Applikationen, Fachanwendungen) enthalten die eigentlichen Funktionalitäten und sollten als eigenständige Projekte betrachtet und ggfs. auch von unterschiedlichen Projektteams entwickelt werden können. Jede Softwarelösung, die auf der Content Plattform basiert, stellt eine Content Applikation (Szenario) dar. Business Szenarien konsumieren die Kernfunktionen aus der Content Plattform und müssen sich auch gegen diese authentifizieren.

Content Components (Services)

Content Components verfügen über eine Reihe von Funktionalitäten und Microservices, und Content Applikationen werden mit ihnen gebaut und angereichert. Denn in einer dienstleistungsorientierten Welt sind Unternehmen nicht mehr daran gebunden, eine Suite zu kaufen, die alles bewerkstelligt. Diese Services und Funktionalitäten können von mehreren Plattformen oder Anbietern kommen und zusammen mit anderen Anwendungen interagieren.

Content Components sind z.B. WorkFlow Engines, MFA Services (Multi Factor Authentifizierung auf Anwendungsebene), Reporting, Dashboards, Formulare, Search, Scheduler, Notifications, Monitoring, Analyse Tools, Data Security, Signaturen, PDF Generierung oder Archivierung.

Was steckt genau dahinter und welche Vorteile ergeben sich?

Auf den Punkt gebracht geht es nun um Content Applikationen (mobil, webbasiert), die den End User (Mitarbeiter, Partner, Kunde, Lieferant) in die Lage versetzen, sein Geschäft besser (schneller, kostengünstiger) abzuwickeln, basierend auf einer umklammernden Content Plattform mit verschiedenen, daraus resultierenden Content Components.

Werden diese „Content Services“ nun vernünftig eingesetzt, entsteht nun die Chance die ECM Funktionalitäten zu entzerren, um anschließend flexibler und modularer als mit einer statischen ECM-Suite (nicht Strategie!) die Business Requirements anzugehen. Diverse moderne API´s oder auch CMIS bieten hier hervorragende Schnittstellen.

Um auch den Bedürfnissen der Anwender gerecht zu werden, und um auch schnelle Ergebnisse in Form von Pilotanwendungen liefern zu können, sollten diese Plattformen mit dem Ziel entwickelt werden, eine moderne und technisch hochaktuelle State-of-the Art Basis zu schaffen, um heutige Digitalisierungsprojekte schnell und effizient umzusetzen.

Flexible Skalierung und Clustering sind im Cloudzeitalter eine Selbstverständlichkeit.

Die Möglichkeiten des Hostings müssen ebenso flexibel sein, das heißt, dass der Betrieb in einer privaten Cloud, onPrem oder in der Public Cloud (Amazon AWS, Microsoft Azure) zur Auswahl stehen sollte und somit auch Herstellerneutral ist!

Eine Content Plattform bietet Entwicklern – in vereinfachter Form ausgedrückt – einen umfassenden „Werkzeugkasten“ (Komponenten, Best-Practices, Richtlinien) um schnell und effizient Arbeitsabläufe digitalisieren zu können. Darüber hinaus entspricht die Content Plattform der „Werkstatt“, die dafür sorgt, dass die Content Components (die „Werkzeuge“) in einer sicheren und geordneten Art und Weise angewendet werden.

Das bedeutet – wiederum in vereinfachter Form – dass bei neuen Digitalisierungsvorhaben nicht jedes Mal die „Werkstatt“ und der „Werkzeugkasten“ erfunden werden müssen, sondern dass sich alle Beteiligten ausschließlich auf das Projekt und den Content Applikationen selbst konzentrieren können.

Das Projekt selbst (bzw. das Szenario) würde, um im Bild der „Werkstatt“ zu bleiben, einem speziell angefertigten „Prüfstand“ entsprechen. Dieser wird in der „Werkstatt“ mit den zur Verfügung stehenden „Werkzeugen“ entwickelt.

Die Besonderheit des Prüfstands (hier: Szenario) ist, dass dieser nach Fertigstellung beliebig dupliziert werden kann.

Um das Bild komplett zu machen, kommen nun noch die Mandanten und Tenants ins Spiel. Diese entsprechen den „Fahrzeugen“, die auf einen „Prüfstand“ müssen. Damit ist das Bild vollständig: ein „Fahrzeug“ (Tenant) auf einem „Prüfstand“ (Szenario) in der “Werkstatt“ (Content Plattform).

Die Flexibilität und Möglichkeiten sowohl in der Entwicklung als auch im Betrieb sind wesentliche USP´s für solche Content Plattformen.

Wenn nun auch noch ein DevOps Ansatz erforderlich ist, also im Lifecycle einer Anwendung eine schnellere und einfachere Bereitstellung während des Betriebes umzusetzen, kommt man um die Automatisierung von Software-Bereitstellungsprozesse zur Erhaltung von Verfügbarkeit und Performance der Zielplattformen nicht herum.

Hinzu kommen die strengen Anforderungen an Security und Datenschutz im Enterprise-Umfeld. Um diese ökonomisch erfüllen zu können benötigt es durchdachte und erprobte Plattformen, auf die sich Entwicklung und Projektleiter verlassen können. Bei der Entwicklung von Content Services sollte somit sehr viel Wert auf die Einhaltung von Sicherheitsstandards zum Datenschutz gelegt werden. z.B. basierend auf den häufigsten Schwachstellen des Open Web Application Security Projects (OWASP), sollten zahlreiche Sicherheitsmechanismen integriert sein.

Wie kann es weitergehen? Aus was bestehen digitale Produkte?

„Content Services“ haben zum aktuellen Zeitpunkt einen sehr technologischen Ansatz.

Für digitale Produkte (Content Applikationen) wird ein Geschäftsprozess benötigt inkl. Geschäftsmodell, API´s und Microservices (Content Components), eine Content Plattform und natürlich gute Architekten und Entwickler. Fertig.

An den Beispielen wie MyTaxi, Netflix, Uber, Number 26, Spotify etc., ist gut zu erkennen, dass Digitalisierung nicht zwingend bedeutet Neues erfinden zu müssen, sondern Vorhandenes clever zu kombinieren!

Use Case gibt es genügend. Was gefordert ist, sind reale und am besten messbare Business Case die mit der Strategie des Unternehmens eine Synergie abbilden.

Wichtige Bausteine der Digitalisierung sind also bereits existierende Technologien und Services, sowie „Content Services“ als Herzstück für Digitalisierungsprojekte. Die Kenntnisse dieser Technologien und Services, ergänzt um die Fähigkeiten diese intelligent zu kombinieren, zu integrieren, zu betreiben und mit kundenspezifischer Softwareentwicklung zu vervollständigen ist hierbei die wichtigste Aufgabe.

„Digitalisierung“ ist doch nichts anderes, als die konsequente Nutzung moderner und vorhandener IT-Technologien, mit dem Ziel Geschäftsprozesse und Abläufe möglichst perfekt zu unterstützen.

„Content Services“ könnten der Ansatz dazu sein, technologisch und strategisch dazu richtig aufgestellt zu sein.

Jubiläums-Newletter-Ausgabe „25 Jahre|Years PROJECT CONSULT“

Gratuliere der PROJECT CONSULT zum 25 Jährigen Jubiläum!

Knapp 18 Jahre für mich eine unentbehrliche Institution.

Vielen Dank für Möglichkeit eines Gastartikels ab Seite 201

„Content Services –

Sind diese nun die Chance für eine erfolgreiche digitale Transformation?“

http://www.project-consult.de/news/2017/25-jahre-project-consult-25-years

Download

Die spannenden Beiträge erwarten Sie hier im Download/Please find all articles:

Im/in PDF: http://bit.ly/PCJub25NL

Link zum Theum-Buch für Web & Mobile /link to web & mobile Theum version: http://bit.ly/PCJub25NLTheum

Longlink: https://project-consult.theum.com/newsletter/index.htm?t=Kunden-Newsletters-ab-2011,2017,201703-Juni

Link ePub /link to ePub version: http://bit.ly/PCJub25NLePub

Jubiläumswebsite

Grüße, Gratulationen & Kommentare / Greetings, Congratulations & Comments

http://bit.ly/Jub25PCHH

Longlink: http://www.project-consult.de/news/2017/25-jahre-project-consult-25-years

Du muss angemeldet sein, um einen Kommentar zu veröffentlichen.